Gabriela Arriagada Bruneau, académica del Instituto de Éticas Aplicadas UC en cargo compartido con el Instituto de Ingeniería Matemática y Computacional (IMC UC) e investigadora del Centro Nacional de Inteligencia Artificial (Cenia), ara la tierra de las Inteligencias Artificiales e invita a mirar un poco más allá, para poder entender los problemas sociales que derivan de esta tecnología, desde diferentes enfoques y a través de un abanico de matices.

En una entrevista exclusiva con Cenia, la investigadora comentó sobre cuáles son estos enfoques o cómo entender de mejor manera qué significa considerar todas las complejidades implicadas en una realidad,así como también, a través de los datos y entrenamiento de modelos, es posible gestar espacios de cuidado e inclusividad.

Un concepto clave que Gabriela nos invita a conocer e instalar en el vocabulario de las IA’s en el presente y futuro es el de “Inteligencia Artificial Sociotécnica”, ¿qué es una visión sociotécnica?

“Yo creo que la función de la visión sociotécnica es contextualizar, es ir tejiendo una narrativa, que va desde lo que nos dicen los datos y lo que reflejan, hasta las decisiones y consideraciones que un desarrollador toma”.

La autora Gabriela Arriagada explica que las estructuras sociales están empujando ciertos desarrollos, donde hay intereses políticos, económicos eimpactos medioambientales, pero también hay problemas éticos más profundos que tienen que ver con discriminación, y todos esos ambitos no son aislados.

Para la investigadora, abordar el tema de los sesgos en IA es más que solo identificar que hay datos de entrada sesgados y hacerse cargo de ellos.

¿Por qué un abanico de matices? ¿Por qué son importantes los diferentes enfoques?

“No podemos hacer ciencia desde la neutralidad, la vista neutral no existe.La ciencia no se hace fuera de factores de nuestros principios, nuestros valores, nuestra experiencia, no sólo porque no podemos aislarnos de nuestra propia corporalidad, sino porque también es necesario que haya corporalidad.Es necesario que entendamos esto, porque si queremos diseñar una aplicación que sea inclusiva para mujeres, inclusiva para personas autistas o para personas de tercera edad, no basta simplemente con preguntar qué creemos que deberían necesitar estas personas”.

Lo que la académica e investigadora sugiere, además de hacer un estudio estadístico, es contextualizar, y eso implica entender las necesidades de ellos y ellas en particular, por ejemplo, en el caso anterior, entender qué es la tercera edad en Chile, qué es el autismo en Chile, qué es la necesidad de la mujer en Chile. La idea es que cuando se tomen las decisiones, haya personas en la mesa que vivan esa realidad.

¿Por qué IA’s y no IA?

“Siempre mencionamos con mi colega, Claudia López, la importancia de hablar sobre “las IA’s”, en plural, y no sólo “de la IA”. Las Inteligencias Artificiales abarcan diferentes sistemas y procesos que puedes utilizar, como aprendizaje profundo, lineal, redes neuronales,etc, pero en el fondo son sistemas que nosotros usamos para diferentes objetivos: clasificación, predicción, identificación y otros, pero en realidad lo importante de distinguir eso es entender que no podemos decidir una ética o sólo una gran idea para hablar de ética de IA, sino, que es cómo diseñamos una inteligencia artificial, una de las múltiples que podrían haber”.

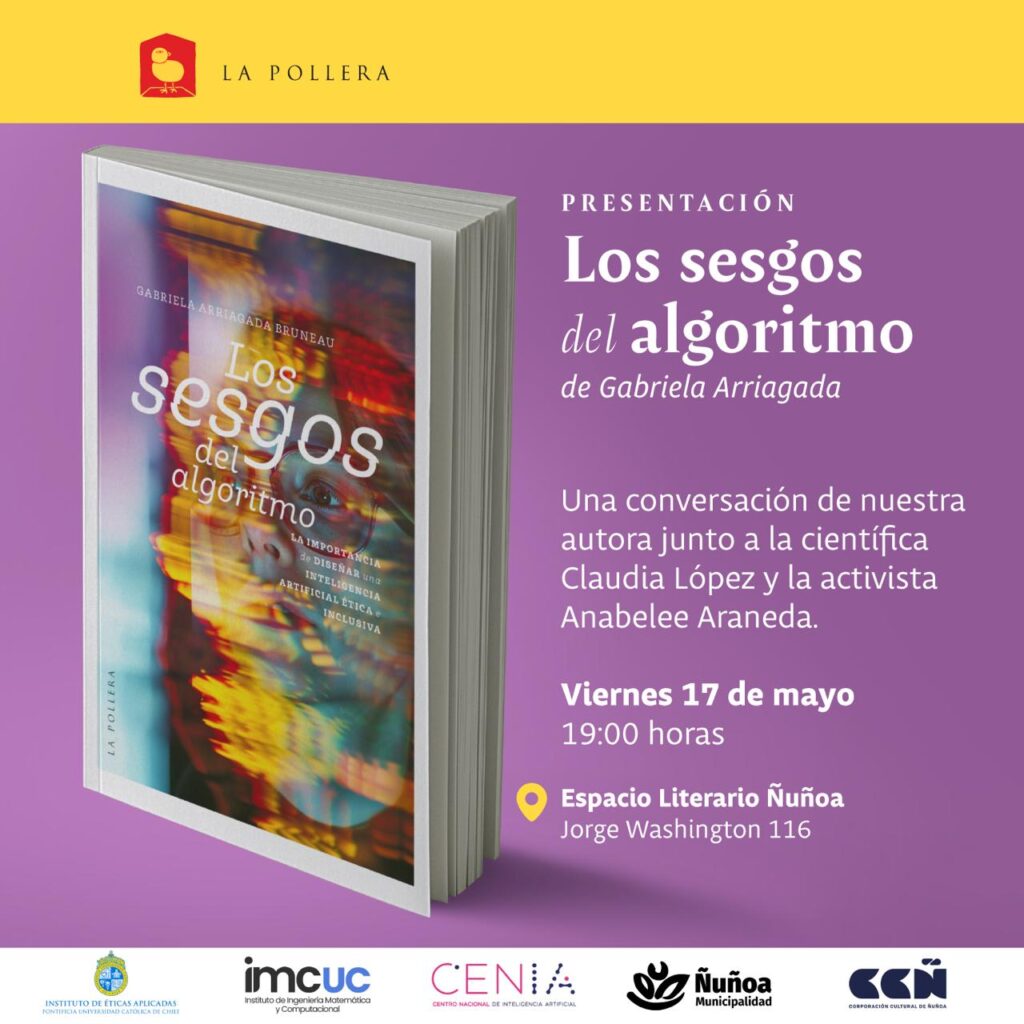

¿Cuáles son las intenciones o motivaciones de escribir “Los sesgos del Algoritmo”?

“Mostrar, contar y entender que mi investigación y mis intereses académicos existen por quién soy y tienen una correlación. Yo no podría investigar algo que no significa nada para mí, y creo que por mucho tiempo la academia se transformó en un lugar donde nos interesaba simplemente producir cosas, y a mí lo que me interesa es conectar gente, conectar problemas, conectar soluciones. Entonces, creo que el gran valor de esto es compartir cómo yo he vivido discriminación.Es un relato sobre mi experiencia y de muchas otras que no conozco.Me importa hacerlas visibles para hacernos cargo del problema, porque no sirve de nada tener tecnología y tener conceptos si esos conceptos no están conectados con la realidad que viven las personas, y diferentes tipos de personas”.

La invitación de Gabriela Arriagada, es a viajar en un recorrido no lineal y de colores. En cuatro capítulos, la inteligencia artificial y ustedes pueden convertirse en cómplices sobre su desarrollo, pero por sobre todo, alinearse con el entorno y enfatizar en la incorporación de experiencias y perspectivas diversas para hacer una de tantas, más inclusiva y transparente.

En voz de la autora, te dejamos el siguiente extracto de invitación a la lectura de la co-evolución:

“La idea es aplicar una ética contextualizada a las necesidades de aquellos grupos que han sido invisibilizados en la sociedad, particularmente, las minorías de género y las minorías neurodivergentes. Desde luego, no vengo a ofrecerles soluciones incuestionables, pero sí compartirles una narrativa, una perspectiva y una experiencia personal para enfocar ciertos problemas éticos y avanzar hacia estas soluciones, las cuales, por supuesto, requieren un trabajo íntimo desde la interdisciplina”.

¿Dónde lo consigo? Puedes adquirir tu ejemplar en el siguiente enlace: https://lapollera.cl/producto-etiqueta/gabriela-arriagada/

Por: Pía Cassone